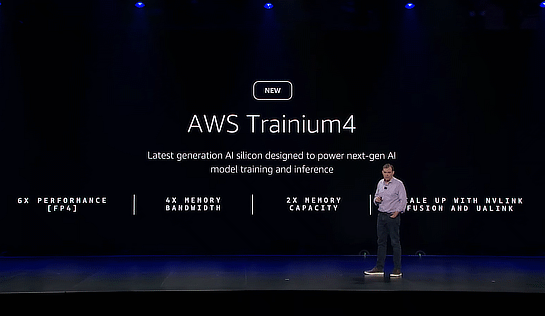

AWS、独自のAI処理専用プロセッサ「AWS Trainium4」を発表。現行のTrainium3の6倍の性能、4倍のメモリ帯域幅を目指す

Amazon Web Services(AWS)は、日本時間12月3日未明から開催中の年次イベント「AWS re:Invent 2025」で、同社が独自開発しているAI処理専用プロセッサ「AWS Trainium4」を発表しました。

2020年に最初のTrainiumを発表

AWSは2020年12月のAWS re:Invent 2020で、従来のプロセッサやGPUよりも高速で安価なAIのトレーニング処理を実現する独自プロセッサとして「AWS Trainium」を発表しました。

そして2023年のAWS re:Invent 2023で第二世代となる「AWS Trainium2」を発表し、昨年(2024年)にはTrainium3を発表しています。

参考:AWS、生成AIのトレーニングに最適化した独自プロセッサ「AWS Trainium3」発表。Trainium2の2倍の性能に

Trainium 4は6倍の性能を目指す

今回発表されたTrainium4は、今回正式サービス化が発表されたTrainium3と比べて1チップ当たり6倍の性能、4倍のメモリ帯域幅と2倍のメモリ容量を目指して開発され、最も大規模なAIモデルをサポートするとしています。

Trainiumはもともとその名称通り、当初はトレーニングのためのチップとして登場しましたが、Trainium2からはトレーニングと推論の両方を処理するチップとなりました。

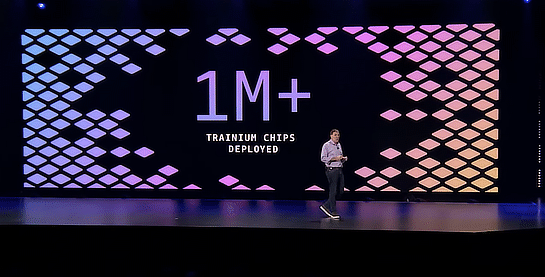

同社はすでに100万個以上のTrainiumを同社データセンター内で展開しており、高速で高効率なAI処理を行っているとしています。

AWS re:Invent 2025

- [速報]AWS、独自の基盤モデル「Amazon Nova 2」発表。マルチモーダルなNova 2 Omniも登場

- [速報]AWS、基盤モデルをユーザーが独自データで学習させてカスタマイズできる「Nova Forge」発表

- [速報]AWS、障害が発生すると人間より先にAIが調査分析、対処法まで報告「AWS DevOps Agent」プレビュー公開

- [速報]AWS、AIがフィードバックから学びつつ自律的に開発を行う「Kiro autonomous agent」発表

- AWS、コンテナではなくEC2インスタンスでサーバレスを構築できる「AWS Lambda Managed Instances」リリース

- AWS、AIエージェントでレガシーなWindowsアプリをコードもDBもモダンな「.NET+Aurora PostgreSQL」に自動変換。AWS Transformリリース

- AWS、Apple M3 Ultra/M4 Maxチップに対応したMacインスタンス発表

- AWS、独自のAI処理専用プロセッサ「AWS Trainium4」を発表。現行のTrainium3の6倍の性能、4倍のメモリ帯域幅を目指す

- Amazon S3が大幅強化、保存できるオブジェクトサイズが最大の50TBに拡大、バッチ処理速度は10倍速に

- AWS、マネージドデータベースを最大35%安く使える「Database Savings Plans for AWS Databases」発表

あわせて読みたい

Amazon S3が大幅強化、保存できるオブジェクトサイズが最大の50TBに拡大、バッチ処理速度は10倍速に

≪前の記事

AWS、Apple M3 Ultra/M4 Maxチップに対応したMacインスタンス発表