[速報]マイクロソフト、AIモデルをWindows/macOSローカルで実行可能にする「Azure AI Foundry Local」発表

マイクロソフトは日本時間5月20日未明に開幕したイベント「Microsoft Build 2025」で、WindowsおよびmacOSのローカル環境でエッジ環境に最適化されたAIモデルを実行可能にする「Azure AI Foundry Local」を発表しました。

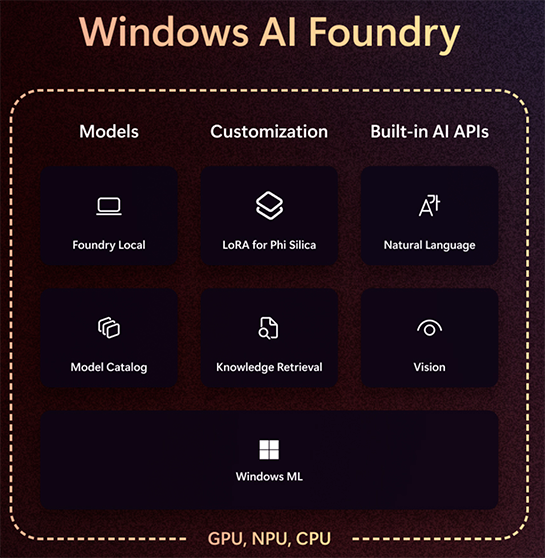

同時に、これまでWindows Copilot Runtimeと呼ばれてきたWindows上のAI実行環境を「Windows AI Foundry」としてアップデート。Windows上での「Azure AI Foundry Local」をこれに統合することも明らかにします。

Azure AI Foundryとは

Azure AI Foundryは、クラウドサービスであるMicrosoft Azure上で生成AIの実行基盤および生成AIアプリケーション開発や管理に必要な機能やツールを一元的にまとめたプラットフォームです。

OpenAIやClaudeを始めとするさまざまなAIモデルを選択して実行するためのカタログ、生成AIを利用してアプリケーションを構築するためのSDKやアプリケーションテンプレートなど、生成AIアプリケーション開発のためのさまざまな機能が備わっています。

30種類以上のAIをWindows/macOSで実行可能

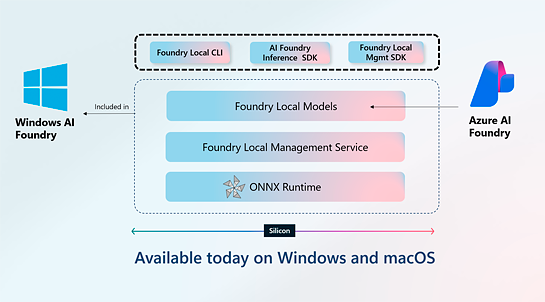

今回発表されたAzure AI Foundry Localは、このAzure AI Foundryの機能の一部として、WindowsとmacOS上のローカル環境で、これらエッジ環境に最適化された30種類以上のAIモデルを選択して実行可能にするというものです。

これによりWindowsやmacOSのオフライン環境でセキュリティやプライバシーに配慮したAIアプリケーション開発が可能になります。

Windows AI FoundryはAzure AI Foundry Localを統合

Windows上では、このAzure AI Foundry Localを統合した「Windows AI Foundry」が提供されます。

Windows AI Foundryはインテル、AMD、NVIDIA、クアルコムのCPUやGPU、NPU環境に対応し、AIモデルの選択から最適化、ファインチューニング、アプリケーションの開発を含むライフサイクル全体をWindows上で実行可能。

またAzure AI Foundry LocalのAIモデルカタログだけでなく、OllamaやNVIDIA NIMのAIモデルカタログも統合し、簡単にさまざまなAIモデルにアクセスし、Windows上へデプロイして実行できるようになります。

Microsoft Build 2025での主な発表

- [速報]マイクロソフト、Windows Subsystem for Linux(WSL)のコードをオープンソースとしてGitHubに公開

- [速報]マイクロソフト、AIモデルをWindows/macOSローカルで実行可能にする「Azure AI Foundry Local」発表

- [速報]マイクロソフト、WindowsがMCPをサポートすると発表。AIエージェントでWindowsやアプリとの連携が可能に

- [速報]マイクロソフト、Copilotに対してユーザーが追加学習を行える「Microsoft 365 Copilot Tuning」発表

- [速報]「GitHub Copilot Coding Agent」パブリックプレビュー。AIにIssueをアサインすると、解決に向け自律的にプログラミング

あわせて読みたい

[速報]マイクロソフト、WindowsがMCPをサポートすると発表。AIエージェントでWindowsやアプリとの連携が可能に

≪前の記事

[速報]マイクロソフト、Windows Subsystem for Linux(WSL)のコードをオープンソースとしてGitHubに公開