OpenAIやマイクロソフト、メタ、シスコ、AMDらがイーサネットをAI向けに広帯域かつ低遅延にする「Ethernet for Scale-Up Networking 」(ESUN)プロジェクト開始

生成AIの急速な普及と成長によって、データセンターにおける生成AIの学習や推論処理を高速かつ効率化するために、より広帯域で低遅延な高密度ネットワークへの要求が高まっています。

こうした用途のために、Compute Express Link(CXL)やNVidiaのNVlinkなどいくつかのソリューションは市場に投入されているものの、これらは多くのベンダが求めるようなオープンで相互運入可能なニーズに最適化されているわけではないとして、Open Compute Project(OCP)が「Ethernet for Scale-Up Networking」(ESUN)プロジェクトの開始を発表しました。

OpenAI、MS、AMD、シスコなど主要ベンダが設立

OCPは、2011年にFacebookが中心となって設立したデータセンターのハードウェア設計をオープンソース化する団体です。

今回発表されたESUNプロジェクトは、このOCPの年次イベントとして10月にカリフォルニア州サンノゼで開催された「OCP Global Summit 2025」で発表されました。

設立メンバーにはAMD、Arista、ARM、Broadcom、Cisco、HPE Networking、Marvell、Meta、マイクロソフト、NVIDIA、OpenAI、Oracleが名前を連ねています。

AIのための高速かつ低遅延なイーサネットを実現

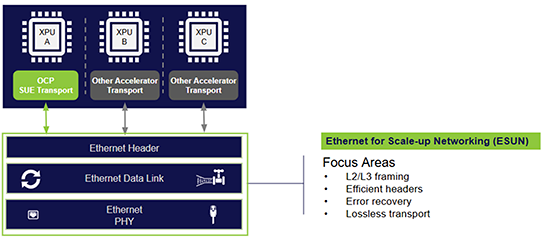

ESUNプロジェクトでは、AIのためのアクセラレータプロセッサ(XPU)で高性能なクラスタを構築するために、イーサネットをベースにより広帯域低遅延を実現するオープンスタンダードベースのソリューションを実現しようとしています。

Aristaのブログ「The Sun Rises on Scale-Up Ethernet」によると、ESUNプロジェクトではまず以下の技術についてアプローチすると説明されています。

L2/L3フレーミング

低遅延、高帯域幅を要求するワークロードのために、Alヘッダをイーサネット上でカプセル化します。

エラーリカバリ

パフォーマンスを損なうことなくビットエラーを検出し、修正します。

効率的なヘッダー

最適化されたヘッダによって回線効率を改善します。

ロスレストランスポート

既存の標準化された仕組みを活用し、一部のAl ワークロードに不可欠なネットワーク輻輳による性能低下を防ぎます。

あわせて読みたい

IPA 登大遊氏の基調講演、NOT A HOTELの自動化例、コカコーラのAI活用など、情シスが創るビジネスの明日をテーマにしたイベント開催[PR]

≪前の記事

サイバーエージェントがAIアプリ「Dify」のベクトルDBとしてTiDBを選択。AIアプリの全社導入に耐えうる基盤を構築[PR]